Durch Social Scoring entstehen Klassifizierungsschleifen, auf die sowohl der einzelne Mitbürger als auch die Gesellschaft keinen oder nur schwer Einfluss nehmen kann.

Dies führt zur Einschränkungen, Diskriminierung & sozialer Ausgrenzung.

Adrian Preussner

Social Scoring – Chance für ein besseres gesellschaftliches Zusammenleben?

Einleitung

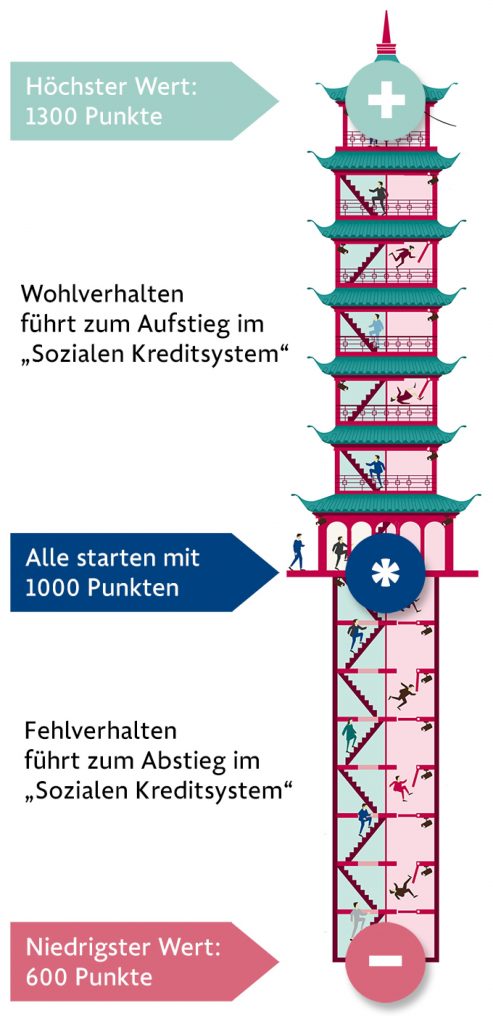

Sieht vielleicht so das zukünftige Social Credit System in China aus?

Mit dem Auto über eine rote Ampel gefahren oder eine Rechnung zu spät bezahlt? 10 Punkte Abzug. Gemeinnützige Tätigkeiten ausgeführt oder den Staatsoberhaupt in sozialen Netzwerken ausreichend gehuldigt? 10 Punkte plus. So oder so ähnlich soll in Zukunft ein Sozialkreditsystem die Vertrauenswürdigkeit der chinesischen Bevölkerung automatisiert bewerten (Siehe Abbildung 1). Zum aktuellen Zeitpunkt ist jedoch noch unklar, nach welchen Parameter das zukünftige System entscheidet, sodass es derzeit lediglich verschiedene Pilotprojekte in verschiedenen chinesischen Regionen gibt. Tendenzen zeigen aber, dass folgende soziale Faktoren im Gespräch sind:

- Online Kaufverhalten,

- Social Media Nutzung,

- Verhalten im öffentlichen Raum und

- das eigene soziale Umfeld.

Bürger mit einem hohen Score erhalten billigere Flugreisen und bessere Kitaplätze, während schwarzgelistete Personen mit Reiseverboten und verlangsamten bürokratischen Prozessen bestraft werden. Je besser das eigene Verhalten das Gemeinwohl stärkt, desto besser soll der persönliche Status werden. Laut YouGov und dem SINUS-Institut kam bei einer Umfragen heraus, dass sich sogar jeder sechste deutsche Bürger sich so ein Konzept in Deutschland vorstellen könnte. Was zunächst als Instrument für ein besseres Gemeinwohl klingt, kann aber auch viele Risiken mit sich bringen. In diesem Position Paper werden diese Risiken genauer betrachtet.

Einmal in der Blacklist – Immer in der Blacklist?

Die Einführung eines Sozialkreditsystem setzt voraus, dass das System reibungslos funktioniert und jegliches Fehlverhalten vom System erfasst wird. Was aber, wenn das System ein Verhalten falsch eingeschätzt hat und der betroffene von seinem Listeneintrag nichts mitbekommen hat? So gibt es Beispiele bei denen betroffene einen Flug nicht antreten durften, weil scheinbar eine Mahnung nicht gezahlt worden ist. Die getätigten Zahlungen wurden vom System nicht erfasst. Betroffene haben auf die Datenerfassung keinen Einfluss, sodass die Anfechtung solche Einträge langwierig und schwierig sind.

Darüber hinaus zeigen weitere Beispiele das solche Systeme anfällig für Cyber Angriffe und Manipulationen sind. So hat ein Polizist in China über 400.000 Bußgeldbescheinigungen aus dem staatlichen Computer gelöscht (vor allem von Führerscheingefährdeten Strafpunkten). Im Gegenzug erhielt der Polizist von den betroffenen 42,4 Millionen Yuan (c.a. 5,6 Millionen Euro) Schmiergeldzahlungen. An diesen und weiteren Beispielen wird deutlich, dass die Systeme anfällig für Fehler und Manipulation sind, sodass eine korrekte Bewertung der Vertrauenswürdigkeit nicht möglich ist und die mangelnde Transparenz zu einem verzehrten Wahrnehmung führt.

Unklarheit bei der Benennungsmacht – Wer setzt die Maßstäbe & Indikatoren?

Neben der intransparenten Datenerfassung gibt es auch bei der Benennungsmacht Unklarheiten. Wer bestimmt überhaupt die Maßstäbe und Indikatoren anhand das System später entscheiden soll, wie Vertrauenswürdig eine Person ist? So kann Social Scoring als politisches Machtinstrument missbraucht werden, mit dem oppositionelle und Regierungskritiker stärker bewacht, kontrolliert und bestraft werden. Der Technikfolgenabschätzer Armin Grunwald schätzt das Potential von Social Scoring dabei wie folgt ein:

„Gegen die Überwachungs- und Kontrollwerkzeuge, die die Digitalisierung möglich macht, waren die Möglichkeiten, die Hitler und Stalin hatten, Kinderspielzeug.“

Armin Grunwald

Durch das bewerten der Social Media Nutzung und des Online Kauf Verhalten wird zudem die Benennungsmacht stärker privatisiert, wodurch neue Machtgefälle entstehen. Kreditwürdig oder nicht? Gesund oder krank? Apps & Soziale Netzwerke beeinflussen durch ihre Algorithmen die Indikatoren mit denen gemessen wird. Darüber hinaus gibt es keine klare Trennung zwischen privaten und staatlichen Datensammeln. Gesammelte Daten über Social Media oder der Fitness App können für politische Interessen missbraucht werden.

Klassifizierung führt zur Diskriminierung

Eines der Standardaufgaben einer künstlichen Intelligenz ist die Klassifizierung. Sie zielt darauf ab Informationen anhand gesetzter Parameter zu verarbeiten und einer Gruppe zuzuordnen, sodass sich ein Muster erkennen lässt. Diese Klassifizierung wird zwangsläufig zu Diskriminierung führen. Anhand eines Beispiels aus Österreich, bei dem Algorithmen künftig die Arbeitsmarktchancen von Arbeitslosen bewertet, wird dies deutlich. So werden Arbeitslose in drei Kategorien eingeteilt: Gute Chancen (A), Mittlere Chancen (B) & Geringe Chancen (C). Frauen und älteren Menschen wird dabei eine geringere Arbeitsmarktchance zugemutet. Ein Missbrauch dieser Klassifizierung kann zur Diskriminierung bei der Jobvergabe führen, da ein A-Kandidat eher eingestellt wird als ein C-Kandidat.

Neben dem Alter und Geschlecht gibt es weitere Faktoren nach denen eine KI zwangsläufig klassifiziert: Ethnien & Wohngegenden. Wenn auf Grundlage von Algorithmen in einer Wohngegend eine erhöhte Polizeipräsenz veranlasst wird, steigt die Anzahl der registrierten Straftaten zwangsläufig. Die Fehlinterpretation der erhöhten Kriminalität führt zur Umverteilung der polizeilichen Ressourcen. Die reproduzierten Feedbackschleifen der Algorithmen verstärken eine verzerrte Wahrnehmung und können ethnische Minderheiten oder spezielle Wohngegenden diskriminieren.

Durch ein Social Scoring System kann es so zu zwei Ränder in der Bevölkerung kommen: Die eine Bevölkerungsgruppe fällt in einer Abwärtsspirale immer tiefer, während die andere Gruppe in einer Aufwärtsspirale immer mächtiger wird.

Fazit

So vielversprechend Social Scoring Modelle im ersten Moment für das Gemeinwohl klingen, so gefährlich sind sie es zu gleich. Die mangelnde Transparenz und Anfälligkeit für Manipulation zeigt, dass solche Modelle nicht zuverlässig die Vertrauenswürdigkeit einer Person wiederspiegeln können. Hinzu kommt, dass solche Modelle Menschen mit diversen Einschränkungen nicht zuverlässig berücksichtigen werden können. Darüber hinaus ist unklar, wer letztlich die Benennungsmacht für Regel und Parameter setzt. Sind es Regierungen, die das System als politisches Instrument ausnutzen oder sind es private Unternehmen, wie Facebook, Amazon oder Alibaba, die durch Ihre Plattformen und Algorithmen einen enormen Einfluss auf die Datenerhebung haben? Zusammenfassend entstehen durch Social Scoring Modelle Klassifizierungsschleifen, auf die sowohl der einzelne Mitbürger als auch die Gesellschaft keinen oder nur schwer Einfluss nehmen. Dies führt zu Einschränkungen, Diskriminierung und sozialen Ausgrenzungen.

Quellen

Allgemein

„Sesame-Credits“ – Macht China Überwachung zum Spiel? https://politik-digital.de/news/sesame-credits-china-ueberwachung-148275/

Interview mit Armin Grunwald https://www.focus.de/finanzen/boerse/digitalisierung-autonome-autos-sind-ein-muss_id_10084022.html

Jeder sechste Deutsche findet ein Social-Scoring-System nach chinesischem Vorbild gut https://www.heise.de/tp/features/Jeder-sechste-Deutsche-findet-ein-Social-Scoring-System-nach-chinesischem-Vorbild-gut-4297208.html

Wie China die digitale Ãœberwachung vorantreibt https://www.deutschlandfunk.de/social-score-wie-china-die-digitale-ueberwachungvorantreibt.676.de.html?dram:article_id=442872

Soziale Kontrolle 4.0? Chinas Social Credit Systems https://www.eurozine.com/soziale-kontrolle-4-0-chinas-social-credit-systems/

Einmal in der Blacklist – Immer in der Blacklist

China’s Chilling ‘Social Credit’ Blacklist https://www.hrw.org/news/2017/12/12/chinas-chilling-social-credit-blacklist

So absurd ausgefeilt ist Chinas Ãœberwachungssystem https://www.welt.de/wirtschaft/article192029849/Social-Scoring-So-absurd-ausgefeilt-ist-Chinas-Ueberwachungssystem.html

Unklarheit bei der Benennungsmacht – Wer setzt die Maßstäbe & Indikatoren?

„Diese Systeme kriechen in unseren Alltag“ https://www.tagesspiegel.de/gesellschaft/social-scoring-diese-systeme-kriechen-in-unserenalltag/24098020.html

Künstliche Intelligenz in der Verbrechensbekämpfung https://www.boell.de/de/2018/01/29/kuenstliche-intelligenz-der-verbrechensbekaempfung

Klassifizierung durch KI führt zur Diskriminierung

One Month, 500,000 Face Scans: How China Is Using A.I. to Profile a Minority https://www.nytimes.com/2019/04/14/technology/china-surveillance-artificial-intelligence-racial-profiling.html

„Diese Systeme kriechen in unseren Alltag“ https://www.tagesspiegel.de/gesellschaft/social-scoring-diese-systeme-kriechen-in-unserenalltag/24098020.html

Künstliche Intelligenz in der Verbrechensbekämpfung https://www.boell.de/de/2018/01/29/kuenstliche-intelligenz-der-verbrechensbekaempfung

Arbeit aus dem Automaten https://www.sueddeutsche.de/digital/digitalisierung-arbeitslosigkeit-jobcenter-1.4178635

Was der neue AMS-Algorithmus für Frauen wirklich bedeutet https://futurezone.at/netzpolitik/was-der-neue-ams-algorithmus-fuer-frauen-wirklich-bedeutet/400617302